Thèse présentée pour obtenir le grade universitaire de docteur en

Sciences du Langage

Céline HIDALGO

Résumé

La musique et la parole requièrent l’élaboration d’informations acoustiques qui changent dans le temps. De plus, la parole, et bien plus encore la musique, possèdent toutes deux un certain degré d’organisation temporelle, un certain degré de régularité dans le temps qui leur confère un caractère rythmique. Les stimuli de nature rythmique ont la particularité de pouvoir être anticipés par le cerveau et des études en linguistique et neurosciences ont montré que plus le cerveau est capable d’anticiper les évènements auditifs, meilleure est la qualité du traitement des stimuli. Les enfants sourds, bien que bénéficiant d’un input auditif de plus en plus précis grâce aux implants cochléaires ou aux prothèses conventionnelles et d’une prise en charge précoce, n’atteignent pas des niveaux de langage homogènes et souffrent toujours de difficultés de perception en milieux bruyants ou lors de conversations quotidiennes à plusieurs. La situation conversationnelle présente un contexte complexe, nécessitant l’activation de la voie audio-motrice pour anticiper et s’adapter aux variations de la parole de son interlocuteur notamment au niveau temporel. Dans ce travail de thèse, nous avons cherché à analyser, grâce à des mesures électrophysiologiques et comportementales, si un entrainement rythmique actif d’une durée de 30 minutes, stimulant la capacité d’anticipation de structures temporelles, pouvait avoir un effet sur les capacités de perception et d’accommodation temporelles de l’enfant sourd dans une tâche de dénomination en alternance avec un partenaire virtuel. Nous avons également testé les capacités rythmiques de ces enfants à différents niveaux de complexités acoustiques et structurales afin de mieux comprendre leurs déficits sous-jacents de perception temporelle de la parole. Les résultats montrent que les enfants sourds souffrent de difficultés structurer les événements acoustiques selon différent niveaux de hiérarchie (Hidalgo, Truy & Schön, en préparation) mais qu’un entrainement rythmique de 30 minutes versus une stimulation linguistique ou auditive, permet d’améliorer leurs compétences de perception et de production temporelles de la parole dans une situation d’interaction (Hidalgo, Falk & Schön, 2017; Hidalgo, Pesnot Lerousseau, Marquis, Roman, Nguyen, Schön, soumis)

I. Le rythme, une propriété importante pour la perception de la parole

1. Rythme de parole : un rythme musical ?

D’un point de vue physique, la musique comme le langage sont composés de sons complexes de différentes fréquences, intensités et durées qui se succèdent dans le temps. Autrement dit, lorsque nous écoutons de la musique ou la parole d’un interlocuteur, notre cerveau reçoit, en continu, un flux de stimulations acoustiques. Pour que ces deux activités fassent sens, notre cerveau doit en première instance parvenir à segmenter temporellement ce flux quasi-continu en unités qui seront pertinentes pour l’appréciation de la musique et la compréhension du langage. Sans le rythme, un auditeur ne pourrait pas créer du sens à partir des notes de musique qui se succèdent les unes après les autres, ni comprendre aisément le sens d’un discours.

Afin de structurer l’information auditive lors de l’écoute de la musique, le cerveau aura tendance à percevoir les durées des et surtout les intervalles temporels qui les séparent sons comme réguliers. Ainsi, les éléments temporels, i.e. notes ou intervalles, ne vont pas être appréhendés en fonction de leur durée absolue mais selon les rapports de régularité qu'ils entretiennent. Par exemple, les notes de musique ne vont pas être classées selon leur durée réelle en millisecondes (e.g. Do = 900 millisecondes et Si = 450 millisecondes) mais seront catégorisées selon les rapports simples de durées. En reprenant l’exemple ci-dessus, le Do sera considéré comme étant deux fois plus long que le Si. Le Do pourrait aussi durer un peu plus ou bien un peu moins et être encore perçu comme le double de la durée du Si. C’est grâce à ces rapports de durées des évènements et/ou entre les évènements que nous pouvons reconnaître des rythmes familiers lorsqu’ils sont joués à des tempi différents.

Dans la parole, la sensation de rythmicité est également présente mais cette rythmicité sera différemment perçue en fonction des langues. Des langues comme l’Anglais, le Russe ou l’Allemand ont été opposées, en termes de rythme, à des langues comme l’Espagnol ou le Français. Pike (1947) et Abercrombie (1967) ont ainsi défini deux groupes rythmiques de langues : des langues dont le rythme serait basé sur l’apparition régulière d’accents, dites stresstimed, et d’autres langues basées sur l’apparition périodique des syllabes dites syllabletimed. Une troisième classe de langues, nommée moratimed et marquée par des intervalles réguliers entre des consonnes géminées ou des voyelles longues (i.e. Honda contient deux syllabes mais trois mora : ho-n-da), a également été répertoriée ; cette classe contenait des langues comme le japonais (Pike, 1947; Abercrombie, 1967). Cependant, les études acoustico-phonétiques ne sont pas parvenues à démontrer une stricte régularité d’apparition autrement dit l‘isochronie des accent-syllabes-mora dans les différentes classes de langues comme pour la musique (Dauer, 1983). En se basant sur la notion de durées relatives, de nouvelles recherches ont tenté d’analyser le concept de régularité mais à partir des durées des voyelles et des consonnes (Ramus, Nespor, & Mehler, 1999) ainsi que la durée des intervalles qui sépare le début d’émission de chaque phonème dans différentes langues (Grabe & Low, 2002). Cette mesure, nommée Pairwise Variability Index, a permis de réaliser un nouveau classement des langues et bien que certaines langues semblent appartenir à un groupe commun, la catégorisation des langues en classes rythmiques distinctes selon ces critères, reste à appréhender avec précaution (Cummins, 2002). Cependant, la nature perceptuelle du rythme a poussé les chercheurs à mesurer la régularité non pas directement dans le signal acoustique mais plutôt dans le comportement des auditeurs, pour tenter de définir l’indice qui permettait de percevoir une rythmicité dans la parole. Ainsi, des études réalisées dans les années 70-80 (Marcus, 1981; Morton, Marcus, & Frankish, 1976) ont montré que lorsque des auditeurs doivent déterminer si des séquences de chiffres sont prononcées régulièrement ou pas ou produire des séquences de syllabes en rythme sur un métronome, ils n’utilisent pas le début du mot, i.e. l’onset, pour déterminer une régularité des intervalles dans la parole mais un point situé approximativement dans les 2/3 de la montée d’amplitude de la voyelle de chaque syllabe. C’est à partir des intervalles qui séparent ces points “perceptuels” nommés perceptualcenters ou pcenters, que les auditeurs parviendraient à percevoir et produire une régularité dans la parole, donc à ressentir ce qu’on peut assimiler à une pulsation dans la musique.

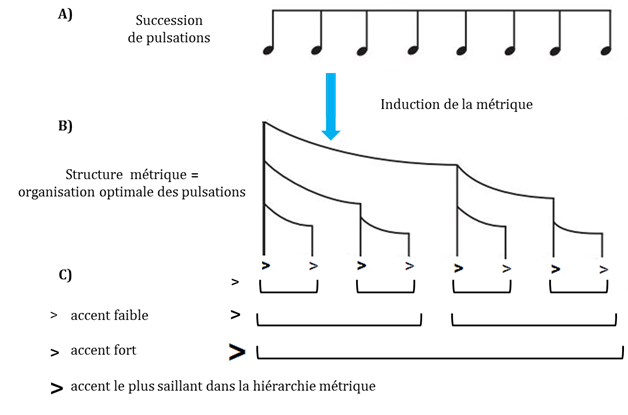

La pulsation ou beat en musique est une structure temporelle qui émerge perceptuellement de l’organisation régulière des durées entre les notes autrement dit du rythme de surface. En régularisant les rapports de durée entre les notes, le système perceptif génère une structure régulière de base, une période de référence qui est maintenue même en l’absence d’évènement dans le signal acoustique (figure 1.1).

Figure 1.1. Représentation de l’induction de la pulsation adaptée de Fitch (2013). Panel

A) Notation du rythme musical dans lequel sont insérées des silences. Panel B) Signal acoustique musical duquel ressort une succession d’évènement saillants (Panel C). Panel

D) depuis ces évènements saillants, notre système perceptif extrait une régularité d’apparition des évènements, la pulsation, qui pourra être perçue même en l’absence d’une matérialisation dans le signal acoustique (voir les silences dans la notation musicale) (Fitch, 2013).

Selon la Dynamic Attending Theory (DAT) (Large & Jones, 1999), l’émergence de la pulsation proviendrait de la capacité du système perceptif à distribuer l’énergie de l’attention sur des points perçus comme saillants dans le rythme musical grâce à un

mécanisme de couplage de nature oscillatoire entre le cerveau et le signal acoustique (Figure 1.2). Une fois l’oscillateur en phase avec le signal musical, celui-ci continuerait à osciller régulièrement ce qui maintiendrait l’orientation de l’attention dans le temps même en l’absence de signal.

Figure 1.2. Représentation de la synchronisation entre un oscillateur et un stimulus acoustique isochrone extraite de Jones (2016). Panel A) Stimulus isochrone. Panel B) Oscillateur dont l’amplitude de la phase détermine la concentration d’énergie attentionnelle. La phase de l’oscillateur va se recaler en fonction de l’attente du prochain évènement du stimulus. Panel C), lorsque l’oscillateur a suffisamment ajusté sa phase avec le stimulus, la concentration de l’énergie attentionnelle est moins dispersée (wide focus) et devient maximale sur les évènements du stimulus (narrow focus). L’oscillateur en oscillant sur ce nouveau mode synchronisé au stimulus, peut anticiper le prochain évènement en extrapolant son futur moment d’occurrence (Jones, 2016).

L’Attentional Bounce Hypothesis (ABH) (Pitt & Samuel, 1990) considère que le même type de mécanisme est actif lors de la perception de la parole: notre attention se porterait sur des évènements perceptivement saillants et réguliers du signal, en l’occurrence les p- centers, ce qui nous donnerait, selon le même type de mécanisme oscillatoire, la sensation d’une pulsation dans la parole mais plus spécifiquement sur les p-centers contenus dans les syllabes accentuées.

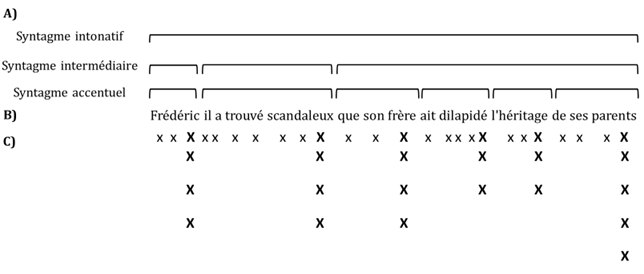

La sensation de rythmicité serait en effet également affectée par une autre structure temporelle de nature perceptive, la métrique. En musique, la métrique est un niveau de structuration du rythme, plus complexe que la perception de la pulsation. La perception de la métrique se situerait à un niveau plus profond de structuration temporelle du signal et consisterait à assembler les pulsations selon une alternance d’accents faibles et d’accents forts d’où émergeraient des patterns d’accents de différentes durées, intégrées les unes dans les autres de manière hiérarchique. La structuration hiérarchique de l’information acoustique en patterns accentuels ferait ressentir certaines pulsations, celles situées dans les hauts niveaux de la hiérarchie, comme plus saillantes que d’autres (figure 1.3).

Figure 1.3. Représentation de l’émergence de la métrique. Panel A) les pulsations successives sont groupées en patterns d’accents fort/faible à différents niveaux (panel B). Panel C) ces patterns d’accents sont ensuite structurés selon différents niveaux de hiérarchie. L’auditeur perçoit ainsi une structuration optimale de l’input acoustique à différentes échelles temporelles.

Dans la parole, il est également possible de considérer une structure métrique qui émanerait de l’organisation de syllabes accentuées (notée X) versus non accentuées notées (x). On sait par exemple qu’il y a des langues donc l’accent des mots se porte généralement à gauche ce qui donne un pattern métrique de type iambique Xx et d’autres langues, qui ont plutôt un pattern métrique de type trochaïque xX avec l’accent à droite (Vaissière, 1991). Ce type de structure récurrente dans une langue permet de fixer un autre niveau d’organisation des p-centers. En outre, si l’on considère l’organisation des constituants prosodiques du français selon la classification de Jun et Fougeron (2002), on peut remarquer qu’ils sont également organisés de manière hiérarchique selon différents niveaux allant de la syllabe au syntagme intonatif avec, pour chacun des niveaux, un degré d’accentuation correspondant (voir figure 1.4) (Jun & Fougeron, 2002). Dans le domaine de la prosodie, l’accentuation en français est dite démarcative et a pour fonction de marquer la frontière droite de chaque constituant de l’énoncé afin de grouper les éléments en unités de sens. L’accent est réalisé par un allongement de la durée de la syllabe et cet allongement sera plus ou moins important en fonction du niveau hiérarchique du constituant dans l’énoncé ; la dernière syllabe du dernier constituant de l’énoncé dans la hiérarchie, le syntagme intonatif, sera par exemple celle qui recevra l’accent le plus important. Cette organisation permet de constituer une grille métrique des énoncés (voir figure 1.4).

Figure 1.4. Représentation de la structure rythmique ou grille métrique de l’énoncé adaptée de Di Cristo (2003).

Regroupement des syllabes en patterns de syllabes accentuées et non accentuées selon la hiérarchie des constituants prosodiques du français et émergence d’une grille métrique. Panel A) Structuration de l’énoncé selon les constituants prosodiques de Jun et Fougeron (2002). Panel B) Enoncé. Panel C) distribution des accents forts et faibles à travers les p-centers et organisation des patterns d’accents selon une hiérarchie de proéminence correspondant aux constituants prosodiques.

Nous aurions donc, en fonction des langues, une représentation perceptive différente de l’organisation temporelle des accents ou grille métrique qui accentuerait la perception d’une régularité dans la parole. Selon la DAT, ce processus perceptif complexe, similaire à celui réalisé lors de l’écoute de la musique, serait généré par le couplage de plusieurs oscillateurs avec les évènements saillants du stimulus acoustique à différentes échelles temporelles. Lorsque les différents oscillateurs se trouveraient en phase avec le beat, cela augmenterait la perception de l’accent le plus haut dans la hiérarchie autrement appelée le downbeat en musique que l’on pourrait assimiler à l’accent de syntagme intonatif dans la hiérarchie prosodique. La perception d’une métrique, en parole comme en musique pourrait être considérée comme une stratégie cognitive supplémentaire pour structurer le signal acoustique et générer des prédictions sur les évènements à venir.

Pour résumer, la perception du rythme serait commune au traitement de la musique et de la parole et elle comporterait au moins deux niveaux : un 1er niveau, le beat en musique et les syllabes (p-centers) dans la parole, et un 2ème niveau la métrique en musique et l’organisation des accents dans les mots et dans les différents constituants dans la parole. L’association de ces deux processus aurait pour effet d'augmenter notre attention sur différents points du signal et possiblement générer des prédictions quant à l’occurrence des évènements de musique et de parole à différents niveaux.

Dans le chapitre qui va suivre, nous allons voir que l’attention et les prédictions temporelles sont des processus cognitifs qui modulent la qualité de traitement de l’input sensoriel en particulier des stimuli auditifs dans des conditions d’écoute difficiles comme la perception dans le bruit ou les conversations à plusieurs.

2. L’entrainment rythmique : ou comment utiliser les propriétés de la temporalité de la parole et du fonctionnement neuronal pour améliorer la perception ?

Dans la partie précédente, nous avons vu que la rythmicité des signaux de musique et de parole, i.e. structure rythmique de surface, beat et métrique, permettait au cerveau de “régulariser” l’input auditif afin d’organiser sa perception ce qui aurait pour conséquence d’orienter l’attention sur les évènements pertinents du signal. Nous allons présenter dans cette nouvelle partie différentes études qui montrent que l’orientation de l‘attention sur des évènements qui apparaissent de manière régulière dans la musique comme dans la parole, améliore le traitement de l’information auditive. Nous décrirons ensuite comment les différentes théories tentent d’expliquer les effets de la régularité sur le traitement perceptif.

Dans le domaine musical, on sait que la présentation de notes de musique à des intervalles isochrones améliore la capacité à discriminer différentes hauteurs (Jones, Moynihan, Mackenzie, & Puente, 2002). Lorsque des auditeurs doivent juger de la similarité de la hauteur de deux notes disjointes, si ces notes sont espacées par d’autres notes apparaissant à des intervalles réguliers, les auditeurs obtiennent de meilleures performances comparées à une condition dans laquelle les notes seraient espacées par des intervalles irréguliers. On retrouve le même type d’effet de la régularité sur les temps de réaction et l’encodage des sons au niveau cortical et sous-cortical. Tillmann et Lebrun (2006) ont par exemple montré que les auditeurs diminuaient le temps de réaction lors de tâches de décision de similarité de hauteur des notes de musique lorsque les notes à analyser étaient insérées dans des séquences régulières plutôt qu’irrégulières (Tillmann & Lebrun-Guillaud, 2006). Tierney et Kraus (2013) ont également montré grâce à des mesures électrophysiologiques (potentiels évoquées corticaux et du tronc cérébral) qu’un son musical (onset) présenté en même temps qu'un extrait musical est mieux encodé au niveau cortical (i.e. onde P1 de plus grande amplitude) et sous-cortical (onde V de plus grande amplitude) lorsque ce son est présenté sur le beat plutôt que lorsqu'il est présenté en dehors du beat. A travers des tâches de discrimination phonémique ou de temps de réaction, des expériences ont également montré l’effet de la régularité de la parole sur le traitement perceptif (Tierney & Kraus, 2013). L’hypothèse de ces études était, comme en musique, que la régularité d’apparition des évènements à différents niveaux de hiérarchie dans le signal permettrait d’orienter, par anticipation, l’attention de l’auditeur sur les points à discriminer et augmenterait les ressources allouées à leur traitement. Quené et Port (2005) ont par exemple montré que lorsqu’on présente auditivement une liste de mots bisyllabiques, les auditeurs détectent plus rapidement un phonème-cible (e.g. le phonème /t/ dans /gato/) lorsque les p-centers des mots sont espacées par des intervalles réguliers comparé à des intervalles irréguliers (Quené & Port, 2005). Pitt & Samuel (1990) ont quant à eux testé les effets de la régularité générée non pas par les intervalles temporels entre les sons de parole mais par la régularité de la structure métrique des mots. Ils ont montré que lorsque des auditeurs entendent des listes de mots qui ont un pattern métrique régulier (e.g. avec un accent final systématique sur la dernière syllabe de mots bisyllabiques: patterns iambique), ils parviennent à détecter plus rapidement un phonème-cible comparé à une condition dans laquelle, les mots qui s’enchainent, comme dans une phrase, n’ont pas des patterns métriques identiques (Pitt & Samuel, 1990).

Une autre manière d’analyser les effets de la régularité sur la perception de la parole est la présentation, avant l’écoute d’un stimulus de parole, d’un amorçage de type rythmique reproduisant ou pas, la structure métrique de la parole. Cason et Schön (2012) ont par exemple fait entendre à des auditeurs des amorces rythmiques régulières suivies de non- mots bi et trisyllabiques. Ces amorces contenaient deux types de structures métriques marquées par des accents faibles et des accents forts qui correspondaient ou pas à la métrique des non-mots présentés. La tâche des participants était de décider, en pressant sur un boîtier de réponses, s'ils avaient perçu un phonème-cible dans les non-mots entendus. Le phonème à détecter était soit présenté sur la périodicité du beat, générée par l’amorce métrique (i.e. un accent fort apparaissait toutes les 700 ms), soit en dehors du beat et cela, dans les deux conditions d’amorce métrique (identique ou différente). Les résultats montrent que les auditeurs détectent plus rapidement les phonèmes-cible lorsque les phonèmes sont présentés sur le beat plutôt que off-beat et que ce résultat est encore amélioré lorsque la métrique de l’amorce correspond à la métrique du non-mot (effet d’interaction). En outre, des mesures électrophysiologiques (potentiels évoqués corticaux) montrent que les auditeurs ont bien détecté la violation de l'amorce métrique dans la condition où la métrique du mot n’était pas identique à l’amorce (N100) ainsi que la violation de la régularité de présentation du phonème sur le beat (P300) (Cason & Schön, 2012).

Pour résumer, dans la musique comme dans la parole la régularité de présentation des stimuli améliore les performances comportementales et électrophysiologiques dans des tâches perceptives. Lorsque le contexte est régulier, l’attention des sujets est facilement orientée sur les points saillants du signal car leur occurrence peut être anticipée. En outre, la perception de la métrique augmenterait cet effet en “attirant” par anticipation, les ressources attentionnelles sur les syllabes accentuées à différents niveaux.

Plusieurs théories ont tenté d’expliquer les processus neurocognitifs qui pourraient être à l’origine de cet effet de facilitation de la régularité sur le traitement perceptif.

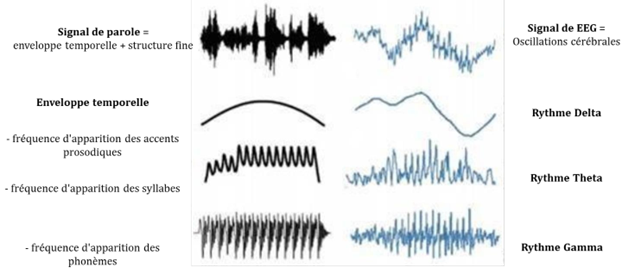

Toutes ces théories partent du constat que l’activité du cerveau est de nature rythmique. Lorsque que l’on pratique un enregistrement de l’activité cérébrale (EEG), on peut en effet voir apparaître spontanément et en fonction des opérations cognitives réalisées durant la tâche, des oscillations rythmiques dans différentes bandes de fréquences. On recense essentiellement quatre bandes de fréquences oscillatoires : delta (1-3 Hz), theta (4- 7Hz), alpha (8-14Hz), gamma (40-80 Hz). Ces fréquences ont la particularité d’être organisées de manière hiérarchique : les plus lentes “contiennent” les plus rapides. On dit aussi que les fréquences rapides sont “nichées”, nested, dans les fréquences plus lentes (figure 1.6). Ces oscillations sont par ailleurs censées refléter les variations cycliques de l’excitabilité d’un ensemble de neurones. Autrement dit, lors du pic d’une oscillation plusieurs neurones se préparent à émettre en même temps, plusieurs potentiels d’action.

Une première théorie propose que selon que les évènements sensoriels arrivent au cortex au moment du pic ou du creux d’une oscillation, leur traitement, du fait du niveau d’excitabilité des neurones, va être respectivement amplifié ou atténué (Schroeder & Lakatos, 2009). Dans cette théorie, les oscillations corticales, par leurs fluctuations régulières, sont considérées comme un moyen pour le cerveau d’échantillonner le flux continu d’informations sensorielles, ou en d’autres termes, un filtre temporel. Plusieurs études dans le domaine visuel, sensorimoteur et auditif, semblent aller dans le sens de cette théorie. Il a par exemple été montré que si la phase des oscillations delta et theta était au niveau d’un pic d’oscillation juste avant l’arrivée d’une syllabe ambiguë, cela permettait aux auditeurs d'améliorer leurs capacités de catégorisation de cette syllabe, autrement dit de mieux la distinguer d’une autre syllabe (ten Oever & Sack, 2015).

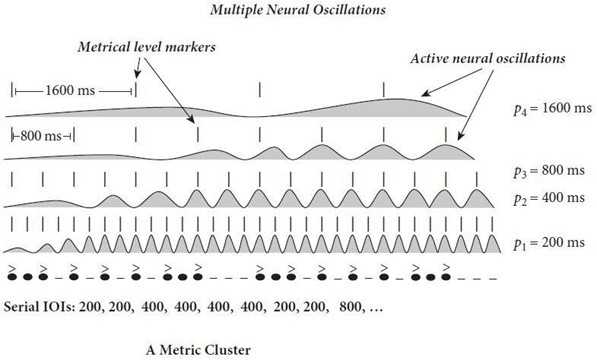

Une deuxième théorie, la Dynamic Attending Theory (déjà évoquée dans la 1ère partie), postule que notre système auditif augmenterait le traitement du signal en synchronisant la phase de ses oscillations corticales avec la phase des stimuli rythmiques. La facilitation engendrée par la régularité serait le résultat du couplage automatique de deux oscillateurs, le stimulus rythmique et un oscillateur du cortex auditif dans le cas d’un stimulus simple comme un métronome ou de plusieurs oscillateurs dans le cas d’un stimulus complexe comme la musique ou la parole (voir figure 1.5). Cette théorie, considère que l’effet facilitateur de la rythmicité dans la musique est un processus de type bottomup, passif, dans lequel les oscillations du système sensoriel seraient entrainées par l’enveloppe temporelle du stimulus acoustique musical. Comme le signal musical, le signal de parole, contient deux types d’informations acoustiques : des informations de nature spectrale et d’autres de nature temporelle. La structure temporelle de la parole peut se décomposer en deux éléments : la structure fine, marquée par des fréquences extrêmement rapides (de 60 Hz à 10 KHz) qui permettent par exemple de différencier deux phonèmes opposés seulement par un trait comme le voisement ou de percevoir les transitions formantiques entre consonnes et voyelles. Le deuxième élément est l’enveloppe temporelle, marquée par des fluctuations lentes de l’amplitude du signal (de 2 à 50 Hz), qui encodent des informations de durée et d’intensité ou encore d’attaque et d’amortissement et qui permettent par exemple de distinguer deux consonnes qui s’opposent par leur mode articulatoire (constrictif versus occlusif). L’enveloppe temporelle permet aussi de percevoir le débit syllabique ou encore le rythme de la parole, marqué par la fréquence d’apparition des phonèmes, des syllabes et des accents (Rosen, 1992). Le rythme de la parole, serait ainsi reflété dans les fluctuations lentes de l’amplitude du signal acoustique qui se décomposent elles aussi en différentes bandes fréquentielles contenues les unes dans les autres comme pour les oscillations corticales (voir figure 1.6). On retrouve ainsi le rythme delta (approximativement entre 0.5 et 3 Hz) qui est la fréquence d’apparition des accents des différents constituants prosodiques, le rythme theta (compris entre 4 et 8 Hz) qui est la fréquence d’apparition des syllabes, et le rythme gamma (entre 30 et 80 Hz) qui est la fréquence d’apparition des phonèmes (Greenberg, 1999). Ainsi, l'enveloppe de la parole, par les informations temporelles qu’elle comporte, transmet un nombre d’informations important à différentes échelles temporelles qui vont être utilisées par le cerveau pour segmenter puis assembler les informations acoustiques de manière pertinente. On pourrait ainsi faire l’hypothèse que la régularité d’apparition des stimuli ou les amorces rythmiques délivrées avant le matériel verbal, auraient favorisé la synchronisation des oscillations neuronales du cortex auditif avec l’enveloppe temporelle de la musique et de la parole. Grâce à ce phénomène d’entrainment, la perception des informations acoustiques fines aurait pu être améliorée.

Figure 1.5. Représentation du couplage de phase de plusieurs oscillateurs avec les différents niveaux de régularité dans le stimulus acoustique extraite de Jones (2016). Plusieurs oscillateurs avec chacun différentes périodes (P1-P2-P3-P4), oscillent en même temps à différentes échelles temporelles correspondant à différents niveaux de régularités du stimulus. Lorsque plusieurs oscillateurs entrent en cohérence de phase, ils créent une relation entre les différents niveaux de la hiérarchie métrique : « metric clusters ». Une fois les clusters métriques établis, l’attention peut être plus flexible et se focaliser sur différents niveaux dans la hiérarchie et anticiper les évènements acoustiques à différents niveaux temporels.

Figure 1.6. Représentation des fréquences dans l’enveloppe temporelle de la parole et dans l’activité cérébrale. A gauche, représentation du signal acoustique et d’une décomposition de l’enveloppe temporelle dans ses différentes bandes de fréquences. A droite, représentation des différentes bandes de fréquences contenues dans le signal EEG et leur caractère “nested” : les fréquences d’oscillation les plus lentes i.e. delta, contiennent les fréquences un peu plus rapides i.e. theta, qui contiennent les fréquences gamma qui sont les plus rapides.

Une troisième théorie la Predictive Coding theory propose que l’alignement de la phase (du pic) des oscillations neuronales avec la régularité des stimuli ne soit pas seulement le fait d’un entrainment passif de type bottomup mais aussi le résultat d’un mécanisme plus actif de prédictions temporelles. Selon cette théorie, la qualité de l’entrainment pourrait être modulée par des processus de type topdown. Une manière de mesurer les effets de ce processus topdown sur la qualité de la perception est de manipuler les attentes temporelles à plusieurs niveaux en l’absence d’une stricte régularité d’apparition (ou isochronie) des stimuli dans le signal acoustique. Dans une récente étude, Breska & Deouell (2016) ont par exemple manipulé la probabilité d’apparition d’un flash visuel : la cible visuelle pouvait soit apparaître sur le beat (onbeat), c’est à dire à un intervalle temporel identique aux intervalles séparant les flashs précédents, soit en dehors du beat (offbeat) (Breska & Deouell, 2016).

Cette dernière condition signifie que la cible avait une plus grande probabilité d’apparaître à un intervalle temporel différent de ceux précédemment présentés. Les résultats montrent que lorsque les cibles arrivent à demoments non attendus, les participants mettent plus de temps à répondre comparé à une condition dans laquelle les cibles arrivent de manière aléatoire. Ce qui est intéressant c’est que ce résultat est valable pour la condition on-beat comme offbeat. En effet, si le résultat obtenu dans la condition onbeat peut être imputable à l’entrainment du cortex visuel sur la régularité du stimulus, le résultat obtenu dans la condition offbeat serait lui, le résultat d’une synchronisation de phase due à la capacité du système à prédire l’occurrence des stimuli selon leurs probabilités d’apparition, et non en fonction de l’isochronie de leur occurrence. Ce type de prédictions, plus globales, faciliteraient également le traitement de l’information sensorielle en orientant les ressources attentionnelles sur des éléments pertinents pour la tâche. De nouveaux paradigmes sont actuellement en construction dans le domaine auditif afin de mesurer les effets de ces prédiction top-down dans le domaine auditif (c.f. Haegens & Zion Golumbic, 2018).

Pour résumer, le fonctionnement oscillatoire de notre cerveau nous permettrait de traiter les stimuli rythmiques avec plus de facilité en définissant des fenêtres attentionnelles de nature temporelles dans le flux de musique et de parole et en synchronisant la phase de ses oscillations sur les évènements prédictibles. L’orientation des ressources attentionnelles sur le stimulus acoustique pourrait être le fruit d’un mécanisme d’entrainment passif (bottomup) mais qui pourrait être modulé par un autre mécanisme plus stratégique, de prédictions temporelles (topdown) à un niveau global. Les oscillations neuronales étant “emboitées les unes dans les autres”, on peut penser que les prédictions plus globales, de type top-down, favoriseraient la synchronisation sur les fréquences lentes de la parole (informations sur la métrique prosodique) qui pourraient “contraindre” les oscillations de fréquences plus rapides à se mettre en phase avec les évènements de parole tels que les syllabes et les phonèmes; l’auditeur qui anticiperait la fin d’une unité prosodique pourrait en effet prédire le décours temporel des syllabes contenues dans cette unité prosodique. Ces deux processus neurocognitifs, bottomup et topdown, de nature temporelle optimiseraient le traitement de la parole aux différentes échelles temporelles et seraient spécifiquement actifs lors de la perception dans le bruit ou de conversations à plusieurs. Ces mécanismes seraient par ailleurs particulièrement développés lors de la pratique de la musique car cette activité cognitive de nature sensorimotrice, sollicite de manière accrue les compétences de traitement temporel à différents niveaux et nécessite une grande précision temporelle.

Dans la partie suivante, nous allons voir que la pratique de la musique améliore la perception de la parole, probablement grâce à une sollicitation accrue de la communication entre les structures auditives et motrices ce qui permettrait un traitement temporel de la parole plus précis de nature prédictive.

3. La pratique musicale : une activité rythmique qui améliore la perception de la parole

Les études mesurant les réponses électrophysiologiques à des stimuli de parole ont pu montrer que chez les musiciens, les neurones du tronc cérébral (colliculus inférieur), dévolus au traitement précoce de l'information auditive, réagissent plus rapidement et reproduisent de manière plus précise les caractéristiques acoustiques du stimulus (Kraus & Chandrasekaran, 2010; Wong, Skoe, Russo, Dees, & Kraus, 2007). Cela leur permet par exemple de mieux traiter et comprendre la parole dans le bruit (Parbery-Clark, Strait, & Kraus, 2011; Parbery-Clark, Skoe, Lam, & Kraus, 2009; Zendel, Tremblay, Belleville, & Peretz, 2015), de traiter avec plus de précision les différences entre les sons du langage (formants vocaliques pour les voyelles et transitions rapides pour les consonnes) (Parbery-Clark, Tierney, Strait, & Kraus, 2012) ou encore de mieux discriminer les changements de hauteur (Besson, Schön, Moreno, Santos, & Magne, 2007; Schön, Magne, & Besson, 2004) intervenant dans la structure de la prosodie et la valeur émotionnelle contenue dans un message verbal. Il est possible que le meilleur traitement de la parole chez les musiciens provienne de leur capacité à traiter l’organisation temporelle des sons avec plus de précision. Les musiciens discriminent des intervalles temporels plus petits comparé aux non musiciens ou des changements temporels plus subtils à l’intérieur de structures rythmiques (Rammsayer & Altenmüller, 2006). Les musiciens présentent également une réponse électrophysiologique (Negativité de Discordance : MMN) plus importante dans le cortex auditif gauche que les non musiciens lors de la détection de violations de la métrique en musique (Vuust et al., 2005), ce qui pourrait expliquer qu’ils parviennent à porter une attention plus importante aux structures métriques dans la musique (Kung, Tzeng, Hung, & Wu, 2011) comme dans la parole. Les musiciens parviennent en effet à mieux détecter une incongruité dans la structure métrique des mots terminant des phrases et leurs réponses électrophysiologiques (P200) à cette incongruité sont plus importantes que celles des non musiciens lorsque la détection de l’incongruité nécessite un traitement actif dans la tâche (i.e. la compréhension des mots) (Marie, Magne, & Besson, 2011). Les enfants musiciens sont également plus performants que les enfants non musiciens à détecter des violations syntaxiques en langage (Jentschke & Koelsch, 2009). Ces résultats semblent signifier que la pratique facilite la perception des structures temporelles contenues dans la musique et dans le langage ce qui influencerait leurs capacités de prédictions dans la parole. Les capacités de prédiction joueraient un rôle important dans l’extraction de régularités statistiques qui sont à la base de la segmentation de la parole. Les musiciens sembleraient lorsqu'il s'agit de segmenter un flux de parole dans une nouvelle langue (Francois & Schön, 2011). Une étude de Vuust et collaborateurs (2008) en magnétoencéphalographie a également montré qu’au plus les musiciens possèdent une expérience rythmique importante (i.e. les musiciens de jazz), au plus leur cortex auditif est sensible à des violations dans les structures rythmiques (MMNm) ; cet effet pourrait être expliqué par leurs capacités à générer des prédictions temporelles de haut niveau reflétées par l’amplitude de la P300m lors des violations métriques (Vuust, Ostergaard, Pallesen, Bailey, & Roepstorff, 2008). Ces prédictions de type predictive coding, implémentées dans les cortex frontal et pariétal, viendraient moduler de manière plus importante, comparé à des musiciens moins expérimentés en pratique rythmique ou des non musiciens, la réponse du cortex auditif à bas niveau. Il est intéressant de noter que la pratique du rythme mais aussi son écoute passive, sollicitent le système moteur (i.e. Aire Motrice Supplémentaire : AMS et cortex prémoteur) (J. L. Chen, Penhune, & Zatorre, 2008). Or, l’activité des structures motrices et les structures frontales semblent liées à la prédictibilité des stimuli. Ainsi, Bengtsson et collaborateurs (2009) ont montré dans une tâche qui n’impliquait aucune action motrice, que l’AMS était plus activée lors de l’écoute de structures de tons organisés selon une structure rythmique comparé à des séquences de tons distribués de façon aléatoire (Bengtsson et al., 2009). Les auteurs (Bengtsson et al., 2009) ont également montré que le cortex préfrontal était plus activé lors de l’écoute de structures métriques et non métriques impliquant une complexité rythmique et des capacités de prédiction plus importantes que le traitement d’une séquence de tons isochrones. Par ailleurs, comme le suggèrent des études montrant l’influence du système moteur dans des tâches de discrimination auditive de hauteur (Morillon, Schroeder, & Wyart, 2014) ou de phonèmes (Cason, Astésano, & Schön, 2015), l’implication du système moteur dans des tâches de perception améliore les performances des auditeurs. Il semblerait donc que la pratique de la musique et en particulier du rythme sollicitant la communication entre les structures motrices et frontales d’une part et les aires auditives d’autres part, soit à l’origine du meilleur traitement des stimuli acoustiques chez les musiciens. L’activation du système moteur lors de l’écoute des sons, augmenterait la synchronisation des oscillations du système auditif sur l’enveloppe des stimuli acoustiques de musique et de parole, ce qui faciliterait l’orientation de l’attention sur le signal acoustique et affinerait leur représentation.

II. L'interaction sociale : un contexte ou le rythme (de parole) est essentiel

Si la rythmicité contenue dans la parole, et de surcroit dans la musique, permet à l’auditeur d’activer des mécanismes neurocognitifs permettant d’améliorer le traitement du stimulus auditif, la situation d’interaction, qui est la situation la plus couramment rencontrée pour le traitement de la parole, va induire des modulations de ces processus (Dimitrios Kourtis, Sebanz, & Knoblich, 2010) et nécessiter des capacités d’anticipation et d’adaptation supplémentaires à celle d’une perception de la parole en situation isolée (Keller, Novembre, & Hove, 2014; Knoblich & Jordan, 2003). C’est pour cette raison qu’il apparaît important de remplacer les mécanismes de perception et de production de la parole dans un contexte interactionnel.

1. Le tour de parole, un contexte interactionnel qui nécessite prédiction temporelle et coordination

Aider un ami à transporter un canapé, jouer au tennis, au basket, danser, ou encore jouer de la musique avec d’autres musiciens requiert une coordination entre les individus pour que l’action puisse aboutir. Les patineurs artistiques doivent par exemple, lors d’une portée, coordonner précisément spatialement et temporellement leurs mouvements afin que cette figure soit réussie. Cependant, cette coordination inter-individuelle nécessite une constante adaptation aux comportements du partenaire qui peuvent, pour certains s’avérer imprévisibles. Par exemple, lors d’un match de handball, pour qu’une passe soit réussie, le receveur doit anticiper la trajectoire et la vitesse du ballon en fonction des mouvements et déplacements de son co-équipier. Mais il doit aussi tenir compte des différents adversaires qui peuvent faire obstacle au lanceur et provoquer probablement une déviation impromptue de son geste de lancer. Ce phénomène, nommé “coordination interpersonnelle”, revêt un caractère dynamique car les individus sont à la fois en constante adaptation mutuelle mais aussi en adaptation avec leur environnement. La coordination qui est présente dans la plupart des interactions sociales, est également présente dans les interactions verbales telles que la conversation qui nécessitent, de la part des interlocuteurs une adaptation ou accommodation temporelle fortement basée sur le rythme. En ce qui nous concerne, nous nous intéressons précisément aux mécanismes neurocognitifs permettant aux interlocuteurs de se coordonner mutuellement pour déterminer avec précision le moment de prise de tour de parole malgré toute la variabilité existante en termes de contenu et de longueur entre deux énoncés provenant de deux interlocuteurs différents.

a. La composante temporelle du tour de parole

Selon l’analyse conversationnelle, les interactions sociales sont régies par un certain nombre de processus et le tour de parole est un des processus majeurs mis en place par les interlocuteurs de manière récurrente dans les différents contextes conversationnels. Un des premiers modèles du tour de parole a été développé par Sacks et al., (1974) dans lequel les auteurs considèrent le tour de parole comme une unité d'interaction sociale construite et réinventée par les interlocuteurs tout au long de la conversation. Deux composantes déterminent un tour de parole : la 1ère composante est définie par les unités verbales c'est- à-dire les mots et phrases utilisés par chaque interlocuteur ; ces unités peuvent être de longueur très différente d'un tour à l'autre et sont appelées Turn Constructional Unit (TCU). La seconde composante est définie comme le moment le plus pertinent pour le changement de locuteur ; elle est nommée le Turn Relevant Place (TRP) (Sacks, Schegloff, & Jefferson, 1974). Dans ce modèle, plusieurs règles comportementales sont définies et doivent nécessairement être mutuellement respectées et comprises par les interlocuteurs afin que la prise de tour de parole puisse avoir lieu à un moment jugé opportun par l’un comme l’autre des deux interlocuteurs. Nous ne développerons pas les comportements non verbaux, ni les traitements lexico-syntaxiques qui sont des indices donnés et utilisés par les interlocuteurs pour déterminer la prise ou non du tour de parole. Cependant, l'analyse de l'organisation temporelle des tours de parole dans la conversation révèle que la plupart du temps, les interlocuteurs parviennent à se coordonner précisément afin que la parole de l'un ne chevauche pas celle de l'autre ni qu'il s'écoule un temps de silence trop important entre deux tours. Les auteurs (Sacks et al., 1974) résument ce principe par minimal gap et minimal overlap.

Selon Auer et collaborateurs (1999), l’organisation temporelle des tours de parole renfermerait un caractère rythmique dont la fonction serait de coordonner l’interaction verbale. Cette rythmicité des échanges permettrait de déterminer si un énoncé s'intègre ou non à un échange conversationnel. Une des stratégies adoptées par les locuteurs (anglophones) pour demeurer coordonnés temporellement lors d’une conversation, serait de modifier certaines caractéristiques de leurs syllabes afin de créer une continuité rythmique entre les tours. En se basant sur la perception des intervalles temporels qui séparent les syllabes accentuées de fin de tour, le locuteur qui se prépare à prendre la parole aura tendance à fixer la durée de la première syllabe accentuée de son tour de parole de manière à créer un intervalle isochrone entre la syllabe de fin tour de son interlocuteur et celle du début de son tour de parole (Auer, Couper-Kuhlen, & Müller, 1999). Une autre stratégie utilisée par les interlocuteurs pour conserver un degré de rythmicité dans l’échange serait la tendance à produire des mots comportant un nombre de syllabes identique d’un tour à l’autre ce qui crée selon les auteurs, une isométrie intra et inter-tour renforçant la perception rythmique de la conversation. Néanmoins, même si les portions de parole contenant une rythmicité forte (mesurées acoustiquement) sont rares, elles sont plus particulièrement présentes vers la fin des tours de parole (Szczepek Reed, 2010a). Le renforcement local (i.e. aux frontières des tours) des indices rythmiques dans la conversation semble indiquer que la conservation de la rythmicité de la parole joue bien un rôle fonctionnel dans la coordination des tours de parole. Dans une étude Szczepek Reed (2010b) a analysé au cours d’interviews, la rythmicité des échanges de paroles entre des locuteurs de deux communautés anglophones différentes. Ce type de conversation, composé d’échanges de question-réponse, a été spécifiquement choisi pour permettre aux auteurs de contrôler le temps de latence dû à la difficulté d’accès lexical. Les deux communautés participant à ces interviews différaient par la rythmicité de l’anglais parlé. En effet, le British English (BE) et le Singapour English (SE) présentent un rythme de parole différent : le rythme du BE qualifié de stresstimed, se reflèterait dans la régularité de la distribution de ses accents et le rythme du SE qualifié de syllabletimed, se reflèterait dans la durée isochrone des syllabes (Szczepek Reed, 2010b). Les résultats montrent que pour ces deux communautés, possédant un rythme de parole différent, la conservation de la rythmicité entre les tours est peu présente ce qui peut altérer la fluidité des échanges et modifier la portée pragmatique de la conversation (Beňuš, Gravano, & Hirschberg, 2011). En effet, si la rythmicité des échanges entre les locuteurs est mise à mal par des temps de latence trop importants ou des chevauchements trop nombreux entre les tours, soit l’interprétation globale des échanges de parole comme activité conversationnelle conjointe est rompue, soit, lorsque cette rupture de la rythmicité apparaît de manière sporadique, elle permet de guider les inférences conversationnelles. Par exemple, un silence d’une durée comprise entre 700 et 800 millisecondes entre deux tours de parole va laisser place à la génération d’une inférence de la part de locuteur. Ce dernier va interpréter le message à venir de son interlocuteur d’une manière différente, (probablement comme une forme de désaccord) de l’interprétation qu’il aurait faite si la réponse avait été articulée selon le délai “conventionnel“ compris entre 0 et 200 ms (Kendrick & Torreira, 2015).

b. Les prédictions temporelles dans le tour de parole

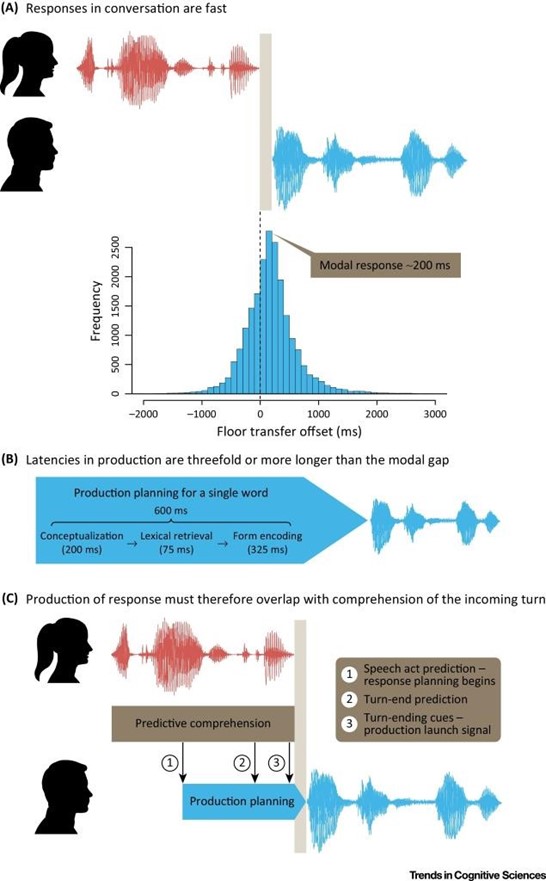

L’analyse temporelle de la prise de tour de parole lors d’un dialogue, montre que le moment auquel les interlocuteurs prennent la parole n’est pas aléatoire. Une étude de Stivers et collaborateurs (2009) a étudié des conversations spontanées dans 10 langues typologiquement éloignées les unes des autres et a pu mettre en évidence une véritable organisation temporelle des tours de parole malgré une variabilité importante dans la structure syntaxique des langues étudiées. Les auteurs ont prélevé les séquences de questions-réponses fermées (oui-non) et mesuré subjectivement, en demandant à un jury d’écoute, si les réponses semblaient retardées ou pas compte-tenu du rythme de la conversation. Ils ont également mesuré objectivement le temps de réponse en millisecondes par rapport à la fin de la question. Ce temps est positif quand il existe un silence entre la fin de la question et le début de la réponse et négatif quand il y a un chevauchement de parole. Lors de l’analyse de cet intervalle temporel dans les 10 langues différentes, on peut voir apparaître un pic unimodal s’étendant en moyenne de 0 à 200 ms (Stivers et al., 2009)(voir aussi l’avis nuancé sur la précision temporelle du tour de parole de Heldner & Edlund, 2010). Autrement dit, les locuteurs appartenant à différentes cultures et parlant différentes langues appréhendent une unité temporelle commune lors de leurs échanges verbaux ; les auteurs parlent d’une organisation universelle du tour de parole. La capacité des locuteurs à respecter ce temps “commun” entre les tours nécessite des capacités de prédiction temporelles. En effet, comme l’explique Levinson et Torreira (2015), la production d’un mot prend en moyenne 600 ms. Or, si les interlocuteurs parviennent à produire leur parole dans les 200 ms qui suivent la fin du tour de parole précèdent, c'est vraisemblablement qu’ils ont anticipé la fin de la parole du locuteur. La distribution du temps écoulé entre la fin du tour de parole du locuteur précédent et la prise de parole du locuteur suivant est nommée le Floor transfer offset (Levinson & Torreira, 2015) (voir figure 2.1). Lorsqu’on demande à des adultes de déterminer le moment le plus probable de la fin des plusieurs tours de parole issus de conversations spontanées, ils estiment ce moment (en pressant un boitier de réponse) en moyenne 200 ms avant la fin des tours. La manipulation des indices acoustiques a également permis aux auteurs de conclurent que cette anticipation était basée sur des indices lexico- syntaxiques (De Ruiter, Mitterer, & Enfield, 2006; Magyari & de Ruiter, 2012; voir Riest, Jorschick, & de Ruiter, 2015 pour une anticipation à partir des indices sémantiques).

Figure 2.1. Représentation du décours temporel des tours de parole extraite de Levinson (2016). A) La parole du locuteur A (en rouge) se termine au point 0 du Floor Transfert Offset marqué par une ligne en pointillée. La durée des silences laissée par les interlocuteurs entre les tours est ainsi calculée depuis ce point 0 jusqu’au début de la parole du locuteur B (en bleu). La médiane des silences inter-tours se situe autour de 200 ms. B) Lorsqu’un locuteur produit un mot, les différentes étapes qui vont de la conceptualisation au début de la réalisation motrice prennent 600 ms. C) Pendant que locuteur A produit son message, le locuteur B génère constamment des prédictions en termes de contenu et de déroulement temporel du message. Ainsi en 1 le locuteur B prédit le type d’acte de parole (e.g. affirmation, question) que va produire le locuteur A en fonction du contenu précédent. En 2 le locuteur prédit le moment de la fin du tour de parole et en 3, en se basant sur les indices acoustiques de la fin du tour de parole, il détermine le moment où il va pouvoir commencer à parler. Pendant ces trois différentes étapes1-2-3, le locuteur B peut ainsi planifier sa réponse et la produire entre 0 et 200 ms en moyenne malgré le temps de planification-programmation que nécessite la production d’un mot (Levinson, 2016).

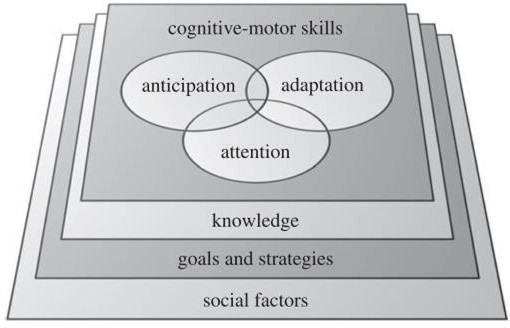

On peut se demander par quels mécanismes neurophysiologiques et processus cognitifs les locuteurs parviennent à anticiper la fin des tours de parole et à s’adapter aux variations temporelles présentes lors d’une conversation. Selon Keller, Novembre et Hove (2014), il est possible d’appréhender les compétences de coordination dans l’interaction verbale à la lumière des compétences requises lors de n’importe quelle action conjointe de nature rythmique car elles requièrent toutes un degré de précision de l’ordre de dizaines de milliseconde et des facultés d’accommodation temporelles. Ce type d’action conjointe, telle que la conversation ou la musique d’ensemble, engagerait des facteurs de réussite communs. Plusieurs facteurs entreraient en jeu lors de la réalisation d’une action conjointe tels que des capacités cognitives et sensori-motrices comme l’anticipation, l’adaptation et l’attention. Ces capacités seraient cependant affectées par d’autres facteurs tels que les connaissances communes des individus sur les règles du système, le degré de familiarité qu’ils entretiennent (e.g. le style de musique ou le degré de formalité de la conversation), le but de l’action et la stratégie utilisée pour réaliser l’action. Des facteurs sociaux tels que la personnalité affecteraient également la réussite de l’interaction (P. E. Keller et al., 2014) (voir figure 2.2).

Figure 2.2. Représentation des facteurs qui affectent la coordination interpersonnelle pendant une action conjointe de type rythmique extraite de Keller et collaborateurs (2014).

2. Les mécanismes d’anticipation et d’adaptation dans l’interaction sociale

a. La convergence

L’interaction sociale engendre naturellement chez les individus de véritables comportements d’imitation réciproque. C’est ce que Chartrand & Bargh (1999) nomment l’effet caméléon. Cet effet est observable au niveau des postures, des mimiques faciales ou encore de certaines caractéristiques linguistiques. Chartrand & Bargh (1999) montrent par exemple que des inconnus qui se rencontrent dans le but de réaliser un travail commun vont automatiquement battre du pied ou se toucher le visage si leur partenaire de travail présente un de ces deux comportements. Ce type d‘imitation est nommé behavioral matching (Chartrand & Bargh, 1999).

Les interlocuteurs en situation d’interaction verbale modifient également leur manière de parler suite à l’influence exercée par leur partenaire conversationnel. Les interlocuteurs ont spontanément tendance à imiter réciproquement certaines caractéristiques de leur parole et selon la Théorie de l’Accommodation et de la Communication (Giles, Coupland, & Coupland, 1991) ces comportements imitatifs auraient pour but d’obtenir un maximum d’affiliation, de solidarité entre les locuteurs ainsi qu’une communication optimale i.e. une communication où les interlocuteurs parviennent à établir une inter -compréhension la plus fine possible (Fusaroli & Tylén, 2012).

Les interlocuteurs vont par exemple utiliser les mêmes structures linguistiques (Branigan, Pickering, & Cleland, 2000) et ce, même lorsqu’ils ne possèdent la même langue (Hartsuiker, Pickering, & Veltkamp, 2004), ils vont imiter des paramètres acoustico- phonétiques tels que l’intensité vocale (Natale, 1975), l'accent (Bourhis & Giles, 1977), une combinaison de caractères acoustiques (durée, fréquence fondamentale, les deux 1er formants, Pardo, 2006) mais également des paramètres avec une dimension temporelle tels que le débit de parole (Manson, Bryant, Gervais, & Kline, 2013; Street, 1984).

Ce type d’imitation, nommée convergence, est corrélée, comme le postulait la Théorie de l’Accommodation et de la Communication, au degré d’affiliation et de compréhension entre les interlocuteurs (Branigan et al., 2000; Garrod & Pickering, 2009; Street, 1984). Ainsi, en imitant réciproquement leurs caractéristiques linguistiques, donc en s’alignant sur des caractéristiques de bas niveau, les locuteurs “se rapprocheraient conceptuellement“ (voir la notion de situationals models de Zwaan & Radvansky, 1998), devenant ainsi plus prédictibles et diminueraient l’effort cognitif engagé dans la compréhension de la conversation (Garrod & Pickering, 2004; Pickering, 2006; Pickering & Garrod, 2007).

Levitan et collaborateurs (2015) ont également montré qu’au plus les interlocuteurs convergent sur des paramètres acoustiques à la fin du tour de parole, au plus ils parviennent à conserver des latences similaires entre les tours. Le phénomène de convergence sur la parole pourrait ainsi également servir aux locuteurs à se rapprocher “rythmiquement” dans la conversation afin de mieux se coordonner (Levitan, Beňuš, Gravano, & Hirschberg, 2015).

b. Le phénomène d’entrainment sur la parole

L’interaction semble être un contexte propice à la synchronisation temporelle entre les individus. Plusieurs études ont en effet montré que lorsque des individus se rencontrent, ils peuvent adopter naturellement des comportements rythmiques similaires et que ces comportements sont synchrones, c’est à dire que les deux individus effectuent des mouvements réguliers en même temps comme lorsque deux personnes marchent côte à côte et qu’elles synchronisent leurs enjambées. Une expérience de Richardson et collaborateurs (2007) a par exemple montré que des individus assis côte à côte sur un rocking-chair vont spontanément synchroniser leurs balancements tout comme des individus qui se voient mutuellement en train de faire osciller un pendule, vont naturellement les faire bouger de manière synchrone en phase (0°) ou en antiphase (180°) à la manière de deux oscillateurs qui se couplent. Ce phénomène d'imitation temporelle, commun aux deux études, s’établit alors qu'aucune instruction de coordination n’a été préalablement donnée aux participants (Richardson, Marsh, Isenhower, Goodman, & Schmidt, 2007). Cette forme d’imitation est appelée interactional synchrony. En se synchronisant mutuellement, les individus réduiraient leur variabilité intra-individuelle et deviendraient plus prédictibles l’un pour l’autre ; ce phénomène pourrait induire une augmentation de la précision des prédictions temporelles et une facilitation de la coordination inter-individuelle (Vesper, Van Der Wel, Knoblich, & Sebanz, 2011).

L’interactional synchrony, autrement dit la synchronisation spontanée en phase et en anti-phase entre des individus peut se retrouver également lors d’une interaction verbale. Himberg et collaborateurs (2015) ont montré par exemple montré que lorsque deux individus construisent une histoire en produisant des mots chacun leur tour à la manière d’une tâche de tapping en alternance, ils adaptent spontanément leur parole de manière à préserver des intervalles temporels de même durée que ceux réalisés par leur interlocuteur. En effet, même si la longueur des mots est très variable d’un tour à l’autre, les individus s’appuient sur le rythme de parole pour placer le début de chaque mot en fonction de l’intervalle temporel précédent. Cette synchronisation de la parole en anti-phase engendre la perception d’une rythmicité dans l’interaction verbale qui persiste même dans la situation où les interlocuteurs ne peuvent pas se voir (Himberg, Hirvenkari, Mandel, & Hari, 2015). Selon Wilson et Wilson (2005), ce serait la synchronisation mutuelle des oscillateurs internes des interlocuteurs sur le débit syllabique, autrement dit le couplage de deux oscillateurs, qui leur permettrait de prédire et préparer temporellement leur prise de tour de parole afin de rester synchronisés (Wilson & Wilson, 2005).

Cependant, comme le montrent d'autres études, il n’est pas nécessaire que la parole présente une structure périodique parfaite pour que des interlocuteurs parviennent à se synchroniser. Lire un texte ensemble est par exemple une activité très facile pour des interlocuteurs inconnus et inexpérimentés. Il semblerait en effet que même dans des conditions où le débit de parole n’est pas régulier, les individus parviennent à développer à partir du signal, des prédictions temporelles leur permettant de lire les mots en même temps à 40 ms près (Cummins, 2003). Ce résultat semble signifier que la parole, même peu régulière comme lors de la conversation spontanée, peut être un vecteur de synchronisation entre les individus et cette synchronisation inter-individuelle, bénéfique à l’interaction (Valdesolo, Ouyang, & Desteno, 2010), semble solliciter, comme la convergence, la voie sensori-motrice.

c. La voie sensori-motrice et les émulateurs internes

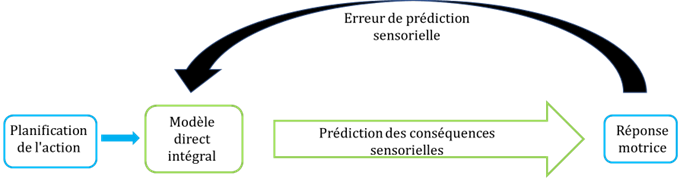

La synchronisation des mouvements des partenaires lors d’une interaction, comme le phénomène de convergence, semblent ressortir d’une synchronisation de type sensori- motrice : le système sensoriel perçoit un stimulus auditif (et/ou visuel) plus ou moins périodique, sur lequel il s’appuie pour envoyer un message au cortex moteur afin d’effectuer une action en fonction des caractéristiques de ce stimulus. Mais le système sensori-moteur fonctionne en boucle, c’est à dire avec des interactions bidirectionnelles entre cortex auditif et cortex moteur. Ainsi, si le système sensoriel interagit avec le système moteur afin qu'il se réajuste suite aux conséquences sensorielles des précédents mouvements, le cortex moteur renvoie également au système sensoriel des informations sur les possibles conséquences sensorielles des mouvements programmés (anticipation). Le système sensoriel peut alors renvoyer des informations au système moteur avant que le mouvement ne soit effectué pour qu’il atteigne la plus grande précision possible. Les conséquences réelles des mouvements, récupérées par le système sensoriel permettront, à force de réitérations, de réduire l’erreur de prédiction. Autrement dit, le système sensori-moteur utilise des mécanismes d’apprentissage par l’erreur qui permettent de réduire facilement la distance entre les mouvements effectués et le but à atteindre (voir figure 2.3 et Pickering & Clark (2014) pour la distinction entre Auxillary Forward Models et Integral Forward Models).

Figure 2.3. Modèle de prédiction de la perception et du réajustement de la réponse motrice dans l’interaction, adapté de Pickering et Clark (2014). Selon le modèle direct intégral (ou Integral Forward Model) de Pickering & Clark (2014), nous utiliserions le même module de prédiction - “modèle direct intégral” - pour anticiper les conséquences sensorielles de nos propres actions et celles de notre interlocuteur mais aussi pour ajuster nos programmes moteurs en fonction des comportements de l’autre. Ainsi, lors de la planification de la parole dans le tour de parole, nous anticiperions les conséquences temporelles de la parole de notre interlocuteur en utilisant les capacités de simulation de notre propre système moteur et nous pourrions ainsi planifier notre parole suffisamment à l’avance afin que le tour commence au moment optimal.

Notre modèle serait systématiquement mis à jour et affiné en fonction de la différence entre les conséquences sensorielles prédites par le “modèle direct intégral” et les conséquences sensorielles produites réellement.

Ce sont ces mêmes interactions entre les systèmes perceptifs et le système moteur qui sont à l’œuvre lors de la perception de la parole.

Depuis la découverte du système des neurones miroir (aire F5 du cortex prémoteur ventral) (Rizzolatti, Fadiga, Gallese, & Fogassi, 1996), plusieurs études ont montré que lorsque nous percevons de la parole, les régions motrices dévolues à la production de la parole telles que gyrus frontal inférieur gauche, le cortex prémoteur ventral et le cortex moteur primaire s’activent. En outre, on retrouve plus spécifiquement l’activation de régions somato-sensorielles liées aux mouvements de la bouche. Par exemple la partie du cortex moteur dévolue à l’activation des muscles de la langue s’active chez l’auditeur lorsque ce

dernier entend des mots impliquant la mobilisation de la langue d’un locuteur (Fadiga, Craighero, Buccino, & Rizzolatti, 2002). De même, stimuler à l’aide de la TMS les régions somato-sensorielles spécifiques à la réalisation articulatoire des certains sons de parole avant la perception de mots contenant ces sons, facilite le traitement en termes de temps de réaction et de pourcentage d’erreurs (D’Ausilio, 2009).

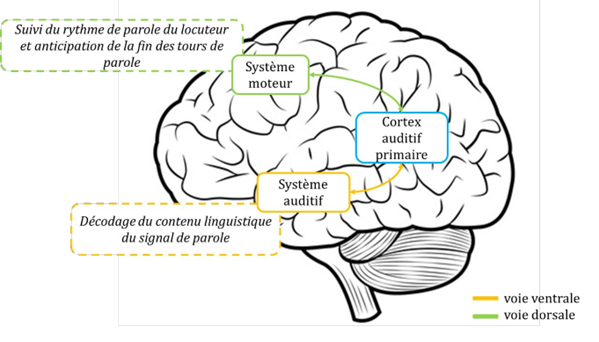

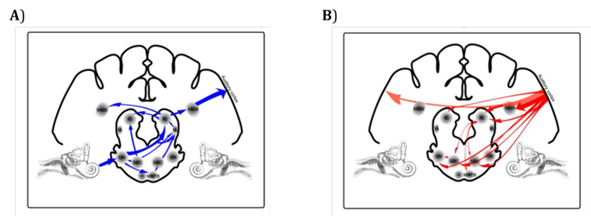

Un modèle de perception de la parole développé par Hickock et Poeppel (2007) met en évidence deux voies de traitement à savoir : une voie dorsale, avec des connexions bidirectionnelles qui relient les régions auditives temporales supérieures aux régions frontales en passant par la jonction temporo-pariétale ; cette voie aurait pour rôle de mettre en correspondance les sons et leurs représentations motrices. Et une voie ventrale qui assurerait la compréhension du message oral (représentations conceptuelle) via des liaisons entre les régions temporales supérieures et inférieures (Hickok & Poeppel, 2007) (voir figure 2.4).

Ainsi lorsque nous percevons de la parole, nous ne percevons pas seulement des éléments acoustico-phonétiques mais, grâce à l’activation des régions motrices, nous intégrons aussi les unités articulatoires correspondantes. En d’autres termes, comme le montre la Perception for Action Control Theory de Schwartz et collaborateurs (2008), nos représentations des unités de parole sont des représentations sensori-motrices (Schwartz, Basirat, Ménard, & Sato, 2012).

Ce modèle rejoint la théorie de la simulation (Wilson & Knoblich, 2005) ou de la résonance motrice qui postule que l’activation de notre système moteur, lors de l’observation de notre partenaire, nous permettrait lors d’une action conjointe, de générer des prédictions sur ses actions à venir et influencerait notre perception. Le système moteur semble en effet très impliqué dans nos interactions sociales, certains auteurs parlent même de “cognition motrice” (Jackson & Decety, 2004). Ce système comporterait un codage commun de l’information avec les systèmes sensoriels et serait le générateur de représentations internes nommées émulateurs. Ces représentations motrices de haut niveau étant partagées entre les individus, elles leur permettraient d'anticiper mutuellement leurs actions ainsi que leurs conséquences sensorielles. Cette théorie a été reprise pour la perception de parole (Gambi & Pickering, 2013) et expliquerait pourquoi l’imitation, qu’elle soit externe comme dans le cas de la convergence ou interne dans le cas d’une imitation motrice endogène des gestes du locuteur de la part l’auditeur, permettrait aux interlocuteurs de mieux se comprendre (Adank, Hagoort, & Bekkering, 2010; Adank, Rueschemeyer, & Bekkering, 2013) et de se coordonner avec précision lorsqu’ils entrent en interaction (Galantucci & Sebanz, 2009).

Scott, Mcgettigan et Eisner (2009) font en effet l'hypothèse d'une activation des cortex moteurs des auditeurs lorsqu’ils sont en train d’écouter un locuteur dans le cadre d’une situation d'interaction verbale. Ils postulent que l'activation de la voie dorsale (reliant les aires sensorielles auditives et les aires motrices en passant par la jonction pariétale) permet, lors du traitement de la parole, une activité motrice finement coordonnée qui assure un déroulement conversationnel fluide. Si la voie ventrale a pour rôle de décoder le message du locuteur d’un point de vue conceptuel, la voie dorsale serait dévolue dans les interactions verbales à contrôler les propriétés temporelles des échanges. Dans la voie dorsale, le rôle du système moteur - système impliqué dans la succession temporelle des actions - serait de suivre, i.e. d’imiter de manière endogène - le rythme et le débit de parole du locuteur et de permettre à l’auditeur d’anticiper la fin des tours de parole (Scott, Mcgettigan, & Eisner, 2009)(voir figure 2.4). Plus précisément, Hadley et collaborateurs (2015) ont montré que dans une tâche lors de laquelle deux pianistes doivent jouer les parties distinctes d’un morceau en alternance (un joue la main la gauche puis l’autre joue la main droite), la perturbation par TMS du cortex prémoteur dorsal et de l’aire motrice supplémentaire au moment de la transition entre les deux pianistes perturbait la fluidité temporelle dans la prise de tour des pianistes. Afin de mesurer l’importance de la simulation des gestes et de la conséquence de cette simulation endogène sur précision de la coordination temporelle dans la tâche, les morceaux ont été préalablement appris soit mains ensemble, autrement dit, pour certains morceaux, les pianistes connaissaient leur propre partie mais aussi celle de leur partenaire, soit les pianistes ont appris seulement la main les concernant. Les résultats montrent que plus la simulation motrice des gestes du partenaire est importante (mesurée pour les morceaux appris mains ensemble), meilleure est la précision de la coordination temporelle lors de la tâche (Hadley, Novembre, Keller, & Pickering, 2015). Novembre et collaborateurs (2014) ont également montré l’importance de la simulation motrice dans l’adaptation temporelle (coordination). Dans cette étude, des pianistes devaient jouer seulement la main droite de morceaux de musique dont la main gauche était enregistrée ; pour certains des morceaux, les musiciens se sont entrainés et les connaissaient par cœur mais pas pour d’autres. Les pianistes devaient ensuite s’adapter aux changements de tempo imposés par la main gauche enregistrée mais lorsque leur cortex moteur primaire a été perturbé (par d’un système de stimulation magnétique transcrânienne) au moment du changement de tempo, les pianistes ne parvenaient plus à s'adapter aux changements avec autant de précision pour les morceaux qu’ils connaissaient par cœur donc pour lesquels ils étaient capables de générer des simulations motrices. Par ailleurs, de manière intéressante, cette même étude a montré qu’au plus une personne est empathique, au plus l’effet de la perturbation de son système moteur lors de la tâche d’adaptation temporelle est important ce qui suggère que le niveau d’empathie pourrait influencer degré de résonance motrice d’un individu lorsqu’il se trouve en situation d’interaction et pourrait avoir un effet sur ses capacités de coordination (Novembre, Ticini, Schütz-Bosbach, & Keller, 2014). La résonance motrice, impliquant l’Aire Motrice Supplémentaire, le cortex prémoteur dorsal et le cortex moteur primaire semble ainsi indispensable à la génération de prédictions temporelles dans les interactions de type musical mais aussi dans d’autres interactions (Dimitrios Kourtis et al., 2010) comme le tour de parole .

Figure 2.4. Représentation du rôle de la voie ventrale et de la voie dorsale dans le traitement de la parole, adaptée de Scott et collaborateurs (2009).

Les résultats de l’étude de Foti et collaborateurs (2016), convergent en effet vers le modèle de Scott et collaborateurs (2009) postulant l’importance de l‘activation endogène du système moteur dans la génération des prédictions temporelles nécessaires au tour de parole. En réalisant un enregistrement EEG simultanément à l’écoute de conversations téléphoniques contenant des paires de questions - réponses car pour ce type de paires, le moment à partir duquel la réponse sera produite est hautement prédictible, ces auteurs ont réussi à montrer que l’anticipation temporelle de la prise des tours de parole avec une durée du silence entre les tours comprise entre 200 et 700 ms (fourchette temporelle qui prédit un accord entre les interlocuteurs et donc une réponse positive immédiate) était reflétée par une réponse évoquée (stimulus-preceding negativity : SPN) générée par des régions postérieures (gyrus temporal postérieur - gyrus supramarginal – cortex prémoteur et le médial cortex préfrontal) correspondant à la voie dorsale alors que le traitement de la réponse affirmative à une question délivrée après une durée de silence supérieure à 700 ms donc engendrant une négation suite à un désaccord entre les interlocuteurs, était reflétée par le complexe P2/N2/P3 générée par des activations allant du gyrus temporal supérieur vers le médial cortex préfrontal mais n’impliquant pas le cortex moteur. Si l’apparition de ce complexe dans la condition de la réponse non prévisible signe une allocation spécifique de l’attention sur les réponses inattendues, l’élicitation de la SPN, dans la condition attendue suggère l’implication de prédictions temporelles guidées par le système moteur lors de la perception d’une conversation (Foti & Roberts, 2016).

Ainsi, l’imitation et la synchronisation comportementale et verbale avec un partenaire sont des stratégies que développent naturellement les individus lors d’une interaction probablement parce - qu'elles impliquent une activation du système sensori-moteur et en particulier le développement de de modèles internes générateurs de prédictions temporelles. La participation importante du cortex moteur dans ces prédictions est une des sources des capacités d’ajustement lors de changement temporels lors d’une interaction.

Un autre processus, complémentaire au phénomène d’entrainement (bottomup et topdown) sur un stimulus auditif et du couplage sensori-moteur, pourrait être à l’origine des prédictions temporelles développées lors de l’interaction. Le couplage de phase de l’activité neuronale de deux personnes en train d’interagir serait en effet un processus supplémentaire qui pourrait expliquer les capacités de synchronie interactionnelle développées au cours d’une interaction (voir figure 2.5).

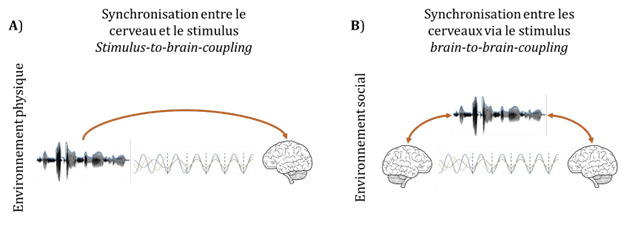

Figure 2.5. Représentation de la synchronisation stimulus-to-brain et brain-to-brain coupling adaptée de Hasson et collaborateurs (2012). A) Phénomène d’entrainement de l’activité oscillatoire sur un stimulus sensoriel extérieur (bottom-up) et de la modulation de l’entrainement par des processus attentionnels et de prédiction (top-down). B) Phénomène d’entrainement entre les activités oscillatoires de deux individus différents qui passe par le phénomène vu dans A) c’est à dire par la transmission entre les individus, d’un stimulus qui va leur permettre de synchroniser leurs activités cérébrales.

d. Synchronisation brain to brain

L’adaptation récente des protocoles expérimentaux utilisant l’imagerie, aux situations d'action conjointe, a permis de mieux comprendre le développement des prédictions temporelles durant les interactions en mesurant simultanément l’activité des cerveaux de deux individus.

Cette technique, appelée hyperscanning, a pu mettre en évidence que la synchronisation comportementale serait en quelque sorte “mimée” au niveau cérébral : lorsque deux individus parviennent à se synchroniser pendant une tâche motrice ou verbale, leurs cerveaux présentent également une activité synchronisée sur différentes bandes de fréquences.

Dumas, Nadel, Soussignan, Martinerie et Garnero (2010), ont réalisé des analyses EEG de cerveaux de couples de participants en train d’imiter réciproquement et librement les gestes de leur main. Les analyses révèlent une activation synchrone des régions centro- pariétales droites des deux individus dans les bandes de fréquences alpha-mu. L'activation synchrone de ces régions, particulièrement impliquées dans la perception temporelle, est retrouvée lorsque les participants commençaient et finissaient spontanément leurs mouvements de mains au même moment, autrement dit lorsqu’ils étaient dans des phases de synchronie interactionnelle (Dumas, Nadel, Soussignan, Martinerie, & Garnero, 2010).

Une autre étude (Kawasaki, Yamada, Ushiku, Miyauchi, & Yamaguchi, 2013) a utilisé un paradigme expérimental semblable à celui utilisé chez Himberg et collaborateurs (2015) en demandant à des sujets de prononcer les lettres de l’alphabet chacun leur tour tout en enregistrant leur activité cérébrale. Entre chaque série de lettres prononcées en alternance avec un partenaire humain, donc avec une parole plus ou moins irrégulière, chaque individu a effectué le même type de tâche avec une machine programmée pour délivrer chaque lettre à des intervalles temporels réguliers. Après analyse de la durée des productions de chaque participant et des intervalles qui séparent leurs productions (i.e. le rythme de parole et d’alternance) les résultats montrent que les rythmes de parole des participants sont mieux synchronisés dans la situation où les individus alternent avec un humain plutôt qu’avec une machine et que cette synchronisation entre les individus est plus importante après que les individus ont été stimulés par une rythmicité commune délivrée par la machine. Par ailleurs, les analyses EEG montrent une activité oscillatoire synchrone de leurs régions pariétales et temporales dans les bandes de fréquences thêta et alpha. En outre, l’augmentation de la synchronisation sur la parole a renforcé le degré de synchronisation de l’activité neuronale entre les individus (Kawasaki et al., 2013). En situation de conversation spontanée, on peut penser que le cortex auditif de l’auditeur serait entrainé sur les basses fréquences véhiculées dans l’enveloppe temporelle de la parole du locuteur ce qui lui permettrait d’anticiper le moment de la fin du tour de parole de ce dernier (Wilson & Wilson, 2005) et que l’activité synchrone dans des aires impliquées dans la perception temporelle et sur des bandes de fréquences beta dans les aires motrices (Novembre et al., 2017) permettrait aux interlocuteurs, par un effet prédictif topdown, de mieux se coordonner (Garrod & Pickering, 2015).

Ces résultats montrant que la synchronisation de l’activité neuronale entre les individus est liée à la synchronisation sur les rythmes de parole mais uniquement dans une situation d’interaction réelle, c’est à dire où les deux individus sont des humains (i.e. variables et adaptatifs) qui réussissent une tâche interactive (i.e. qui atteignent un but commun ou se comprennent), nous amènent à penser que la synchronisation neuronale interindividuelle joue un rôle prépondérant dans la coordination.

Par ailleurs, il semblerait que l’activité cérébrale d’un auditeur qui anticipe la parole d’un locuteur soit liée à une bonne compréhension du message sonore émis par le locuteur. Une étude (Stephens, Silbert, & Hasson, 2010) en Imagerie par Résonance Magnétique Fonctionnelle a été menée sur un individu en train de raconter une histoire a un autre individu. L’analyse de l’activité spatio-temporelle corticale des deux individus montre des patterns d’activité communs entre les deux individus (narrateur et auditeur) dans les aires auditives primaires lors du récit de l’histoire (i.e. lors de la vocalisation) et une activité anticipée (i.e. qui commence avant la perception de la parole) des aires préfrontales et du striatum chez l’auditeur. Cette synchronisation de l’activité neuronale entre les individus diminue lorsque les individus ne parlent pas la même langue (Stephens et al., 2010). Autrement dit lorsqu’un individu écoute un partenaire, les aires dévolues à la perception de la parole s’activent de la même manière chez les deux individus - ce résultat étant certainement dû à la synchronisation des cortex auditifs sur le stimulus de parole -mais surtout, l’écoute de la parole provoque chez l’auditeur une activité oscillatoire qui permettrait d’anticiper la structure temporelle du message oral.

Les locuteurs se serviraient finalement de deux mécanismes distincts mais complémentaires pour se synchroniser et s’adapter dans l’interaction (Galantucci & Sebanz, 2009) : un mécanisme basé sur un phénomène d’imitation sensori-motrice exogène et endogène de type bottomup et un mécanisme de synchronisation mutuelle des activités neuronales permettant la génération de prédictions temporelles de type topdown. Le modèle ADAM, que nous allons décrire dans la partie suivante, pourrait permettre d’expliquer comment les partenaires parviennent à réajuster leur comportement pour faire face à la variabilité de leur partenaire et ainsi maintenir une bonne coordination.

3. Un modèle d’explication de l’adaptation dans l’interaction : ADAM

Comme nous l’avons décrit précédemment, lorsque deux partenaires entrent en interaction, ils exercent une influence réciproque sur leurs mouvements, leur parole et sur la dynamique de leur activité neuronale. Cette influence qualifiée de véritable attraction et contrainte par Fusaroli, Raczaszek-Leonardi et Tylén (2014), est un moyen pour les partenaires de réduire la variabilité intra-individuelle afin de se rendre plus prédictibles pour une meilleure coordination lors de l’interaction (Vesper, van der Wel, Knoblich, & Sebanz, 2012; Vesper et al., 2011). Néanmoins, une coordination réussie est non seulement basée sur la précision temporelle de l’anticipation des actions futures de son partenaire mais aussi et surtout sur l'adaptation mutuelle durant l'action actuelle. L’anticipation temporelle est un comportement prédictif lors duquel un partenaire va anticiper le déroulement temporel des actions ou de la parole de l’autre partenaire alors que l’adaptation est comportement réactif lors duquel le partenaire va réajuster ses actions, sa parole, par un mécanisme de correction de l’erreur en fonction des variations temporelles de l’autre partenaire.